Jak donutit Obamu mluvit sprostě: fake news budoucnosti napodobí hlas i mimiku

Sotva jsme začali řešit dezinformace, propagandu a velkokapacitní šmírovací systémy, ukazují inovace v oboru umělé inteligence, že budeme na současnost brzy vzpomínat jako na selanku.

Aféra společnosti Cambridge Analytica a Facebooku je jen vrcholkem ledovce, který ukazuje na hlubokou strukturální proměnu veřejného prostoru i našeho soukromí. Sběr dat a sofistikované cílení reklamy totiž využívá drtivá většina společností, které působí na internetu. Může ho za malý peníz využít úplně kdokoliv.

Většina lidí na sociálních sítích sdílí neověřené informace a přidává se do skupin, kde sebe i ostatní utvrzují v těch správných názorech. Editoři volí bulvární titulky, které zaujmou, byť často neodpovídají obsahu nebo ho vytrhávají z kontextu. Děláme to sami, docela dobrovolně, vlastně se jen přizpůsobujeme měnícímu se prostředí.

Problém je, že digitální infrastruktura a algoritmy, které nový mediální ekosystém spoluvytvářejí, využívají naši instinktivní a sociální povahu tak, že si to sami nejsme schopní uvědomit. Elektronická sféra vytváří zvláštní komunikační situace, kdy jsme na sociálních sítích nebo v diskuzních fórech zároveň spolu, ale zároveň každý sám.

Tato distance a nové technologické možnosti umožňují inzerentům, zprávařům, komentátorům, blogerům i běžným diskutujícím experimentovat a posouvat hranice možného i zákonného.

Zůstáváme totiž vždy v závětří svého laptopu a mobilu, mimo „fyzický kontext“ setkání, ve kterých jsme k sobě vstřícnější a chceme být s druhými zadobře. Mimo jiné proto, že osobní komunikace nese riziko tělesných následků, zvlášť při setkání s cizími lidmi.

Na internetu se oproti tomu vnímáme a shlukujeme jako nositelé názorových, politických a dalších skupinových identit, ze kterých na sebe můžeme z bezpečných vzdáleností pálit.

Těžba instinktů

Snadnost, s jakou publikujeme, sdílíme nebo jen lajkujeme příspěvky jiných, podporují vyhledávače, sociální sítě, YouTube, zpravodajské či názorové servery tak, aby nás zapojily a co nejdéle udržely na svých platformách. A mohly nás pak nabízet jako potenciální zákazníky nebo voliče obchodníkům a politickým marketérům.

Nejúčinnějším nástrojem, jak nás angažovat, jsou naše instinkty, emoce a sociální chování. Nejvíc se proto šíří novinky, varování, poplašná sdělení, klepy, rvačky, spory, senzace, praktické recepty, vztek a nenávist, reakce na bezpráví, výroky nepřátel a lidí z druhé strany, proti kterým se můžeme vymezit a získat ocenění uvnitř vlastních skupin, stejně jako za videa s věrnými čápy a nekonečně roztomilými koťátky.

Vše ideálně formou hýbajících se obrázků, dryáčnických titulků a CAPSLOCKOVÝCH VÝKŘIKŮ!!!

Takhle jsme ustrojeni a vybaveni pro přežití a platformy i clickbajtové servery z těchto instinktů těží. Podle exprezidenta Facebooku Seana Parkera se algoritmy zaměřují se na zranitelná místa v lidské psychice, a snaží se nás dlouhodobě připoutat vytvořením zpětnovazebné smyčky potvrzující naši příslušnost ke společenství.

Šíření konspiračních teorií, klepů, lží a bulváru není nic nového, novinkou je rychlost a míra, v jaké se to děje. Tím, že se platformy zřekly odpovědnosti za obsah i žánr a algoritmicky podporují sdělení s magickým „enagementem“, vytvořily prostředí, kde se šíří hlavně hlouposti, extrémní názory a žurnalistika čtvrté cenové skupiny. Není důležité, co je pravdivé, ale jestli vás to nutí držet mobil v ruce nebo civět do monitoru.

Veřejný prostor, černá krabička

Část veřejného prostoru se navíc dostává mimo veřejnou kontrolu. Běžní lidé, regulátoři, novináři a další kontrolní instituce, nerozumí fungování algoritmů, které jim zobrazují určitý obsah a nezobrazují jiný.

Dost možná jim nerozumí ani velká část jejich tvůrců neboť jde o komplikovaný strojový systém vyhodnocující tisíce signálů, do kterého čím dál víc zasahují prvky umělé inteligence.

Takzvaný microtargeting se odehrává formou skryté reklamy, u Facebooku skrze tzv. dark posts, které jsou viditelné pouze očím adresátů.

Ruské ovlivňování prezidentských voleb v USA je jen malou ukázkou fenoménu, který náhodou vyplaval na povrch; obsáhlejší pohled do fungování moderního politického marketingu poskytuje rozhovor s volebním hackerem Andreasem Sepulvedou.

Dostáváme se do situace, kdy nikdo přesně neví, co se mezi lidmi šíří. Další omezení přístupu k API rozhraní Facebooku, které kromě nechvalné Cambridge Analytica využívali i slušní výzkumníci zaručující alespoň nějakou kontrolu platformy, tak vposledku znamená nižší transparenci a další ohrožení svobody.

Z veřejného prostoru se stává pověstná černá krabička, u které navíc nevidíme ani na data na vstupu a výstupu, a o příčinných souvislostech se tak můžeme dohadovat.

Je třeba si uvědomit, že jen služby duopolu Googlu a Facebooku využívá víc než dvě miliardy aktivních uživatelů, kteří jsou potenciálním cílem skryté reklamy. Už tato skutečnost představuje ohrožení demokratických principů, které předpokládají jasná pravidla, jejich kontrolu a vynutitelné dodržování.

Zavedení legislativy na ochranu osobních údajů v EU známé jako GDPR a chystaná regulativní opatření v mnoha zemích jsou jen prvním pokusem o základní ochranu individuálního a veřejného prostoru v rodícím se mediálním ekosystému. A z druhé strany i jejich potencionálním ohrožením, jak ukazují první judikáty v postihování hate-speech v Německu.

Rozvoj technologií založených na umělé inteligenci (AI) ovšem představuje budoucnost, ve které se současné problémy jeví jako procházka růžovou zahradou.

Ještě lepší fejky

Velmi brzy se můžeme dostat do situace, kdy se nebudeme moci spolehnout na vlastní uši ani oči. Co hůř: ani na vlastní přátele. Vývoj umělé inteligence pokročil v mnoha ohledech do stavu, který stírá rozdíly mezi pravdou a její nápodobou.

Část těchto systémů je běžně dostupná a analytici a odborníci na umělou inteligenci z Cambridge, Oxfordu, OpenAi a několika dalších renomovaných institucí vydali v únoru zprávu, ve které varují, že jejich využití se dočkáme už v následujících volbách.

V oblasti syntézy řeči představila v roce 2016 společnost Adobe program VoCo, známý také jako Photoshop na lidský hlas. Umí napodobit libovolného mluvčího a doplnit ho o promluvy, které mu prostě dopíšete.

Podle Adobe stačí programu pouhých 20 minut k vytrénování velmi věrné kopie hlasu. V současnosti je ve fázi vývoje a společnost „zvažuje bezpečnostní záruky, které omezí jeho zneužití“.

Podobný program vyvíjí kanadský startup Lyrebird a můžete si ho zdarma vyzkoušet. Výsledky svého projektu uvolnil i tým pracující pro čínský vyhledavač Baidu a počítačoví výzkumníci z Washingtonské univerzity ukázali, jak je možné jakoukoli promluvu synchronizovat s ústy na obličeji libovolného mluvčího.

Na odstranění „robotího“ přízvuku, který je v ukázkách stále slyšet pak pracuje tým Deep Mind, který v roce 2014 přešel pod křídla Aphabet Group, provozující vyhledavač Google.

Skupina Matthiase Niessnera z Technické Univerzity v Mnichově a Michael Zollhöfer ze Stanfordu představili před dvěma lety program, který umožnuje v reálném čase manipulovat YouTube videa a měnit mimiku mluvčích.

Asi největší pozdvižení mezi vtipálky budí aplikace FakeApp (zdarma ke stažení zde), která umí zaměnit obličeje ve dvou libovolných videích. Stačí několik hodin tréningu neuronové sítě a můžete video se svým vystoupením přehrát obličejem libovolného politika.

Nebo někoho zesměšnit tak, že nahrajete jeho obličej do nějaké pornoscény, což donedávna patřilo k oblíbenému sportu zrušené skupiny na Redditu. Při dobře zvolených scénách a dostatečně dlouhém trénování působí nápodoby vysoce realisticky (viz třeba toto video vytvořené redaktorem BuzzFeedu za účelem demonstrace schopností aplikace FakeApp).

Falešní recenzenti

Umělá inteligence byla úspěšně testována v pokusech ovlivnit platformy na hodnocení míst jako je Yelp. Přestože filtrační systémy zachytily část příspěvků, jiné recenze zůstaly nepovšimnuty.

Podle výzkumu Alessandra Bessi and Emilia Ferrara z University of Southern California tvořili chatboti během amerických prezidentských voleb v roce 2016 pětinu diskuzí pomáhajících na Twitteru Donaldu Trumpovi.

Automatizované účty podporovaly i hashtagy a kauzy Hillary Clintonové, ale s přibližujícím se dnem voleb se aktivita botů obou kandidátů vzdálila podle zprávy Oxfordské univerzity v poměru 4:1 v Trumpův prospěch.

Umělí boti falšující profily známých či armády falešných fanoušků napodobující jazyk a styl libovolných subkultur se mohou za nějaký čas stát běžnou realitou (falšování profilů a krádežím identit se věnoval i HlídacíPes.org).

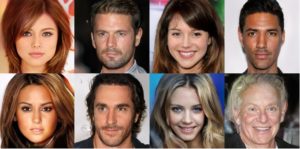

Systém umělé inteligence známý jako Generative adversarial networks (GANs) umí realisticky napodobit či generovat fotky umělých předmětů, zvířat, rostlin nebo lidských obličejů, které jsou k nerozeznání od reálných lidí.

V podstatě jde o souboj dvou neuronových sítí, z nichž jedna generuje obsah a druhá se snaží detekovat, jestli jde o skutečnost nebo o podvrh. Jeden systém snaží obelstít druhý – druhý se snaží nebýt obelstěn tím prvním.

Pomocí GAN vytvořili ve finské laboratoři výrobce grafických čipů Nvidia umělé fotorealistické obličeje ve vysokém rozlišení

Přestože boti v brzké době ani zdaleka nedosáhnou schopnosti delší dobu napodobovat reálné osoby, může při vhodném cílení a volbě témat stačit i nedokonalá podoba k tomu, aby ovlivnili značnou část lidí.

Mohou tak rozšířit repertoár marketingových kampaní i psychologických operací snažících se vytvořit dojem společenské poptávky, vytáhnout z nás údaje ke kreditní kartě, zasáhnout skupinu lidí personalizovanými spamy nebo nás jinak krátkodobě ošálit vytvořením falešné reality.

Úspěšný boj s technologickou hydrou paradoxně předpokládá větší investici do výzkumu v této oblasti a nasazení systémů umělé inteligence na naši ochranu.

Bezmyšlenkovitá regulace, rezignace a hromadný návrat ke sběru bylin by jen vytvořily prostor pro naše ovlivnění ze strany států a společností, které si vůli k moci a víru v budoucnost cíleně pěstují.

Bez rozumné regulace, masivní investice do mediální gramotnosti a kritického myšlení se neobejdeme. A také bez víry v budoucnost.

Partnerem rubriky (Ne)bezpečná síť je Iseco.cz

Pop-up mobil Mobile (207451)SMR mobil článek Mobile (207411)SMR mobil článek 2 Mobile (207416)SMR mobil článek 2 Mobile (207416-2)SMR mobil článek 2 Mobile (207416-3)SMR mobil pouze text Mobile (207431)Líbil se vám tento text? Pokud nás podpoříte, bude budoucnost HlídacíPes.org daleko jistější.

Přispět 50 KčPřispět 100 KčPřispět 200 KčPřispět 500 KčPřispět 1000 KčPlatbu on-line zabezpečuje Darujme.cz

Recommended (5901)

10 komentářů

Pěkně popsáno a shrnuto.

Bohužel se bojím jedné věci: Obrovská spousta lidí po celém světě touží po senzacích, které dokonce víc a víc vyhledávají. Největší čtivost mají články o lidském neštěstí, velkou sledovanost mají různé reality show ve smyslu čím nižší úroveň, tím lépe a některé televize působí svým vysíláním zpráv jako černá kronika.

Budou potom chtít být „gramotní“, když senzace na ně působí jak droga a když „nemuset přemýšlet“ je tak příjemné a jednoduché?

Bojím se toho, že místo lidí (slušného chování a empatie) opět zvítězí zase jen peníze.

Dnes to zmínila i paní doc. Švihlíková…cituji:

Vládnoucí elita tohle dobře ví a začíná svá privilegia bránit,“ konstatovala Švihlíková a upozornila na dvě věci, které se na nás řítí. „Jednou je GDPR, což je šílenost, která tu je proto, abychom nemohli komunikovat mezi sebou. Aby se lidi nemohli spojovat a šířit informace,“ domnívá se. „Byla jsem teď v Brně a tam mi říkali, že se jim hroutí normální spolek zahrádkářů, mají problémy zajistit si provoz,“ řekla k tomu ekonomka. Druhý je takzvaný boj proti fake news. „Má se stanovit celoevropské ministerstvo pravdy a lásky, které má dohlížet na to, co a jak se bude psát. Je to namířeno k tomu, aby se zavíraly alternativní weby. Tato opatření jsou ale známkou toho, jak se jim to hroutí a nemají to pod kontrolou a ztrácejí své pozice,“ uzavřela Ilona Švihlíková.

Ano, také to tak vidím, „perestrojka“ komunistického režimu nezabrala před léty, nezabere ani nyní. Režim nesmyslů a diktátu se rozpadne do nicoty. Do té doby bude okolo sebe kopat a bušit jako bolševické zrůdy na konci 90 tých let. Zákazy, příkazy, omezování svobody…všeho. Skandování „se sovětským svazem na věčné časy“ je naprosto totožné se stejnými výkřiky o „více Evropy“, „více evropských hodnot“. Omyl, to není Evropa, a to nejsou evropské hodnoty, které chci (chceme)! To je neomarxistické zvěrstvo, jakýsi „eintopf“ multikulti africko islámského neandrtálismu, LGBT a genderově politicky neziskovými „estébáky“ placenými ze zahraničí, kupodivu ze Západu!!! Ne z Ruska! Tento projekt šílenců a toho nejsmradlavějšího hnoje nemá šanci na úspěch!

Mám zato, že nás čeká „nová“ ďábelská doba, kdy život budou mít z principu méně složitý jednodušší lidé, kteří nedohlédnou rafinovanosti a záludnosti nových výzev a triků těch, kteří budou tímto způsobem bránit svoje „výdobytky“ snažení na poli ekonomickém (bohatí), kteří budou obratně používat nejen jimi ovládaných politiků, ale také hrozeb nových technologií komunikace k zastrašování pomocí IT specialistů (které zaplatí dostatečně zase jen oni) k mlčení inteligentnější části populace (tzv. mlčící menšina), tak, aby každý pochopil, že se stát (přeneseně) o každého postará, jak on se (si) zaslouží. K tomu účelu se buduje i GDPR a dle mne má sloužit především k znemožnění rozkrytí minulosti právě „ovladačů“ společnosti. O těch tzv. obyčejných občanech stát ví dnes již vše ve svých databázích a ti, kteří mají své „právo“ na utajení právě ze svého postavení VIP si potřebné informace vždy opatří. Takže GDPR je jen vějičkou na jakési právo na tajemno pro všechny, ale je to nesmysl, neboť o tajemství se ucházeli vždy zločinci, mafiáni a podobná verbež. Že se dopustilo zneužívání dat občanů firmami a institucemi v zájmu vyšších zisků a bezuzdného marketingu je jiná věc. To by měl hlídat stát, jenže mnozí činitelé státu z toho nepochybně těží také nejen politicky. Takže všechny avizované nástrahy nových časů jen naznačují, jak se o nás bude nucen postarat stát (sami na to nemůžeme stačit – budeme hloupí a naivní) a proto budeme muset pustit „chlup“ a vzdát se jakýchsi svobod (pracovat ne), pokud toužíme po klidu na svou práci a štěstí mimo ni!

Výsledek generování obsahu pomocí AI?

Vypadá to doopravdy dobře!

Nekdy mam pocit, ze tady v diskuzich na HP uz nekolik takovych islamofobnich a rusofilnich botu pusobi. A nekolik humanoidu/robotu mame i v parlamentu.

Máte něco se smysly? Nepracují dobře.

Establishment se poslední dobou nějak nudí a řeší hlouposti. Za dřívější doby by „aktivista“ hodil kámen do výkladní skříně, dneska místo toho jen napíše nějaké sprosté výhružky a nesmysly na Facebooku. Až když mu to začnou mazat, půjde ven, běhat s Molotovovým koktejlem v ruce…

Ale vůbec ne, pořád jde o principy, které formuloval před více než 200 jistý pan Phineas Barnum. Technologicky sice dost velký progres, ale principy jsou pořád stejné- Jistě že si čtenáři vybírají podle bombastických titulků (což pochopili velmi rychle dokonce i v dobách reálného komunismu pouliční prodejci Večerní Prahy), jistě že je zajímají více překvapivé informace , jistě že se baví politickou parodií jistě že si své názory předávají a sdílejí (takže kvůli tomu už do hospod mocnářství nasazovala c.k. policie konfidenty, aby za projev svobodných názorů dostávali lidi do kriminálu).

Ale – stejně tak voliči dobře vědí, že jim politici dost častou lžou, že dost často neplní své politické sliby a programy, a už vůbec ve většině případů nezastupují zájmy svých voličů a dost často si hrabou z veřejných zdrojů pro sebe.

Tudíž – pokud se nemá ani zbytek důvěryhodných médií zdegenerovat do bulváru (jistě by to pro ně bylo ekonomicky výhodnější), by bylo vhodné kdyby politologové a sociologové dokázali jasně formulovat proč lidé volí ve volbách jak volí.. Zda protože je někdo mediálně oklamal a nebo zkrátka proto že předešlí zvolení politici zkrátka ten stát řídili (z pohledu těch voličů) špatně – a lidé je chtějí nahradit jinými? ??????

Jenomže, na tom není nic špatného, to je jeden z principů demokracie.. A jak praví pointa mého oblíbeného vtipu „na tom jsme se přece dohodli předem“—-

Kdo má v rukou tisk, televizi a rozhlas, má v rukou celkové veřejné mínění i nálady společnosti. Manipulovat, vnucovat jí falešné ideologie formou, že to dnešní konzumní společnost přijímá jako pravdivé a správné. Ptejte se, kdo řídí média a za jakým účelem? Tam, kde se vláda bojí svých občanů, tam vládne určitá demokracie. Tam, kde se občané bojí své vlády, tam vládne tyranie. Celý ten boj s fake news, je jen zástěrka pro cenzuru a ovládnutí prostoru. Podobně jako boj s terorismem od 11. září 2001 jsme na tom hůř než tehdy. Západ válčí na stále více bojištích a pomalu, ale nezadržitelně se sám stává jedním z nich. Nejde jen o fake news , ale i nastolování témat. Technika, kterou se manipuluje s veřejností. Něco se zcela zamlčuje, jiné věci se naopak zveličují. Média politickou realitu vytváří, ale díky sociálním sítím není již tak úspěšná viz. vítězství Trumpa a Brexit.

Zásahy Moskvy se staly univerzálním vysvětlením všeho, co se děje kdekoliv, oživuje se tím studenoválečný rámec chápání světa. Je to logické pokud Moskva mohla zvrátit americké volby, což média dychtivě naznačují, tak by všichni politici v celé té naší EU měli věřit Kremlu, který ostatně rozhodne, kdo bude jejich příštím prezidentem.

Znáte mainstreamové novináře – oni řeknou: My jsme nikoho nemanipulovali, jen holt jsme věrně občanům reprodukovali to, co šířil nějaký novodobý Hilter nebo Goebbels. A měli jsme to vše ověřeno hned z několika zdrojů, od „světových“ zpravodajských agentur, politiků, diplomatů, státních administrativ, OSN a dokonce i z wikipedie. No, je sice pravda, že nějaká opoziční média měla jiné informace – ale to přece byli agenti Ruska, konspirátoři, i blázni a paranoici a to se přeci nedalo zveřejňovat. Tož asi tak.